Artificial Intelligence

Google Rapid and Accurate Image Super Resolution

Già nel mese di novembre, Google aveva presentato una tecnica di apprendimento automatico che migliora le immagini a bassa risoluzione e sfocate. Questa tecnica, chiamata Rapid and Accurate Image Super Resolution, sta venendo utilizzata in Google+ per il trasferimento di immagini ad alta risoluzione con un risparmio di bandwidth del 75%.

I metodi precedenti per ingrandire le immagini consistevano nell’aggiungere più pixel provocando un “appannamento” spesso marcato e rendendo nella maggior parte dei casi l’immagine sfocata.

Rapid and Accurate Image Super Resolution (RAISR) funziona attraverso l’utilizzo di algoritmi di machine learning per ottenere lo stesso risultato in maniera più intelligente. In particolare RAISR conserva le forme ed i dettagli della foto originale, producendo un risultato molto migliore delle tecniche usate sino ad ora.

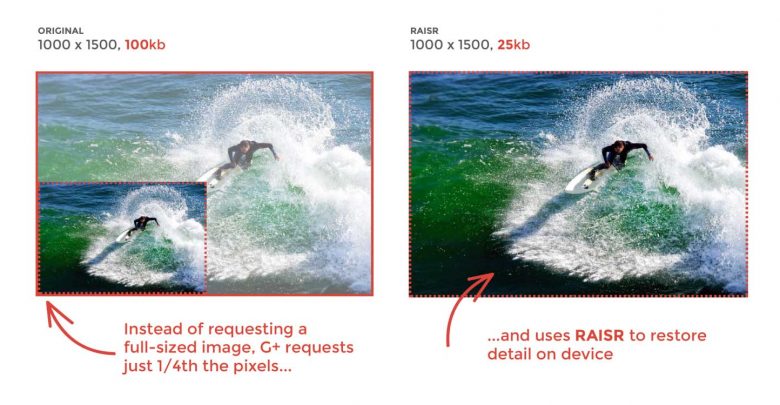

Poche settimane dopo la presentazione dello scorso Novembre, questa tecnica di machine learning è già usata in Google+. In un futuro molto prossimo Google+ smetterà di servire le immagini originali. Invece verrà memorizzata una versione più piccola pari ad 1/4 della risoluzione dell’immagine inviata, applicando RAISR per ripristinare i dettagli sui device che la visualizzano. Ad esempio un’immagine di 100kb 1000×1500 viene memorizzata in un file di soli 25kb il quale viene riportato alla risoluzione originale applicando RAISR.

Al momento questa feature viene fornita soltanto per immagini ad alta risoluzione che appaiono nello stream di Google+ per un campione scelto di devices Android. Parliamo di 1 miliardo di immagini a settimana che già stanno usando Rapid and Accurate Image Super Resolution , con bandwidth utente totale ridotta di 1/3.

Nelle settimane a venire, la tecnologia verrà fornita a copertura più ampia su Google+. Sperabilmente altri servizi come Google Photos potranno beneficiarne. Con tecniche AI di questo tipo applicate in aree sempre più numerose abbiamo un’immediata risposta alla domanda sul perché i produttori di processori e hardware in generale stiano ottimizzando i propri chipsets per il machine learning.

Leggi di più sul futuro del lavoro.

articolo originale: 9to5google.com